23 Aug robots.txt SEO optimieren

Die robots.txt Datei verstehen

Wahrscheinlich kommst du nur selten mit dieser sehr mächtigen Datei in Berührung. Spätestens aber, wenn deine google serach console das meckern anfängt und dir Meldungen zuschickt wie «Neues Problem mit Indexabdeckung auf der Website https://meine-seite.ch/ entdeckt» solltest du dich mit dieser kleinen Textdatei einmal auseinander setzen.

Was macht die robots.txt Datei überhaupt?

Die robots.txt-Datei ist eine kleine Datei, die Suchroboter wie der Googlebot abrufen, bevor sie eine Website crawlen. Sie enthält Informationen dazu,

welche Bereiche einer Website von Crawlern ignoriert werden sollen. Es empfiehlt sich, dem Googlebot möglichst umfassenden Zugriff auf deine

Website zu gewähren, sodass der Content bestmöglich indexiert wird.

Wenn du zb. ein CMS System wie WordPress unterhälst, wird diese Datei meist automatisch angelegt und befindet sich immer im Stammverzeichniss.

Hier sind globale Anweisungen hinterlegt, wie die Suchmaschinen deine Webseite crawlen soll. Es handelt sich also um bestimmte Anweisungen welcher Bot (Abkürzung für Suchroboter) sich auf deiner Webseite bewegen soll und was er dort alles indexieren darf.

Allerdings hat sich das Suchverhalten so verändert, das sie keine Rücksicht auf die dort hinterlegten Anweisungen nehmen. Sie scannen ALLES.

Aber du kannst das Indexieren von Seiten deiner Webseite verhindern oder bestimmte Bereiche blockieren.

TIPP Im Web geistert immer noch die Empfehlung rum: «Blockiert den Zugriff auf die CSS und JS Datein». Lasst es besser bleiben. Erstens hält sich goggle nicht daran und zweitens könntet ihr euch einen Penalty einfangen.

Was ist zu tun bei Fehlermeldungen?

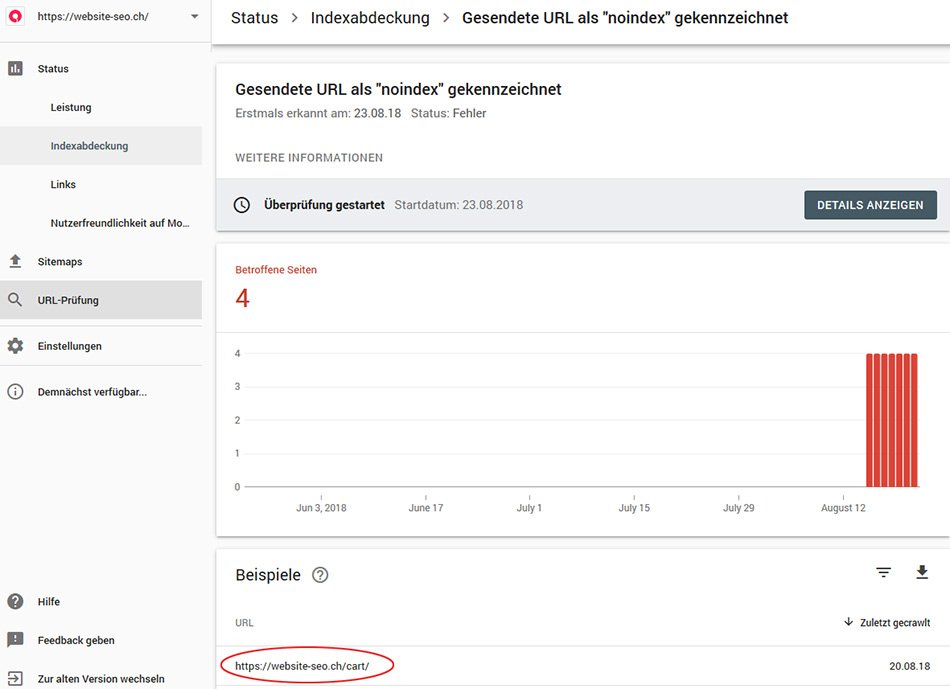

Speziell in Verbindung mit dem Shopping Plugin «woocommerce» bekommst du immer wieder Fehlermeldungen von der google search console angezeigt. Meistens sind die automatisch erzeugten «nofollow» Links von woocommerce dafür verantwortlich.

Google liebt perfekt optimierte Seiten

Also machen wir uns an die Arbeit:

Zuerst öffnest du deine google search console. Wenn du deine Seite dort noch nicht eingereicht hast, dann hole es jetzt nach.

https://www.google.com/webmasters/tools/home?hl=de

1. Links in der Menueleiste findest du den Eintrag Indexabdeckung

2. Dort bitte klicken und es öffnet sich ein Fenster, das dir den aktuellen Zustand deiner indexierten Webseite anzeigt.

3. Wenn keine Fehler vorhanden sind, prima. Meistens findest du dort aber Einzelseiten oder Verzeichnisse die mit «noindex» gekennzeichnet sind.

4. Klicke unten auf Details, danach werden dir alle Seiten angezeigt die irgendwie nicht richtig gecrawlt wurden.

5. Bei uns waren es 4 Woocommerce Ordner, die sinnvollerweise nicht indexiert werden sollten.

6. Diese Verzeichnisse wurden deshalb von uns in der robots.txt mit einem Disallow-Befehl vor dem Indexieren blockiert.

7. Ausserdem wird diese Seite noch mit einem no-index Befehl im Headerbereich der Webseite versehen.

TIPP Durch das Blockieren mittels dem Disallow Befehl könnt ihr das Crawl-Budget optimieren. Der Bot kann sich besser auf die relevanten Inhalte fokussieren und das Crawl-Budget an der richtigen Stelle einsetzen.

Fazit: Ihr erhöht die SEO-Qualität der Webseite.

Die wichtigsten Begriffe und Befehle für die robots.txt Datei

User-Agent: Ist der Name des Suchbots. Mit * erlaubt ihr den Zugriff aller Suchmaschinen.

Disallow – Damit blockiert Ihr den Zugriff auf Datein oder Einzelseiten, oder bestimmter Medien.

Allow – Zugriff erlauben // wird benötigt um eine Ausnahme zum Disallow Befehl hinzuzufügen

Zugriff für alle Suchmaschinen erlauben:

User-agent: *

Disallow:

Zugriff für alle Suchmaschinen verbieten:

User-agent: *

Disallow: /

Nur bestimmte Daten blockieren:

User-agent: *

Disallow: /cart/ (damit sperrst du alle Datein im Ordner cart)

Disallow: /ordner/meine-seite.php (damit sperrst du nur eine bestimmte Seite)

TIPP Nach dem upload der robots.txt in das Hauptverzeichnis deiner Webseite, checke bitte unbedingt ob deine Einstellungen alle okay sind. Dazu gehst du in den nächsten Tagen wieder in die search console und prüfst das Ergebnis in der Indexabdeckung.

Wenn Ihr noch Fragen habt, wir sind für euch da …

Karl Zedarl

Posted at 05:14h, 05 FebruarTolle Adwords Beratung und Umsetzung der Google Werbung. Die Abrufzahlen sind schnell gestiegen und wir konnten unsere Produkte besser darstellen und auch verkaufen. Hoffentlich gehts so weiter :). Wir sind super zufrieden und können die Agentur jedem weiterempfehlen.

Michael Werner

Posted at 20:58h, 19 FebruarDanke für die freundliche Bewertung, es freut uns das alles so funktioniert, wie wir es geplant hatten.